利用 cloudstudio 免费 GPU 时长部署 DeepSeek-OCR

就在上周,人工智能团队DeepSeek AI正式发布全新多模态模型 DeepSeek-OCR。

这款模型以 “探索视觉 - 文本压缩边界” 为核心目标,从大语言模型(LLM)视角重新定义视觉编码器的功能定位,为文档识别、图像转文本等高频场景提供了兼顾精度与效率的全新解决方案,引发技术领域与行业应用端的广泛关注。

本文将带领大家部署在cloudstudio 利用免费时长的GPU资源部署一下带 web 端的项目,一睹为快。

解决什么问题?

“一图胜千言”。当大模型(LLM)面对超长文本(Long Context)时,传统的Tokenizer会产生海量的Token,带来巨大的计算和内存挑战。DeepSeek-OCR提出:为什么不干脆把这些长文本“截图”成一张图片,然后用Vision Encoder进行高效压缩,再喂给LLM呢? 通过这种方式,几千个Text Token可以被压缩成几百个Vision Token,并且信息损失极小!

一键部署项目开源项目地址

DeepSeek-OCR:https://github.com/deepseek-ai/DeepSeek-OCR

DeepSeek-OCR-WebUI:https://github.com/neosun100/DeepSeek-OCR-WebUI

部署教程

打开链接:https://cloudstudio.net/,注册账号,其实就是本博客前面分享的的腾讯云高性能应用服务 HAI 升级产品。

注册后关联腾讯云账号和签到直接赠送 52 算力资源包时长。

然后创建一个应用,注意创建的时候一定要选 AI 模板环境才会分配显卡资源,而不是只有简单的内存和 CPU 的服务器,比如要有 nvida 和 conda,docker 基础环境的。

要部署的现有 web 项目。

直接在控制终端输入下面命令:

git clone https://github.com/rdumasia303/deepseek_ocr_app.git

cd deepseek_ocr_app

cp .env.example .env

docker-compose up -d --build然后耐心等待项目镜像构建完成并启动。

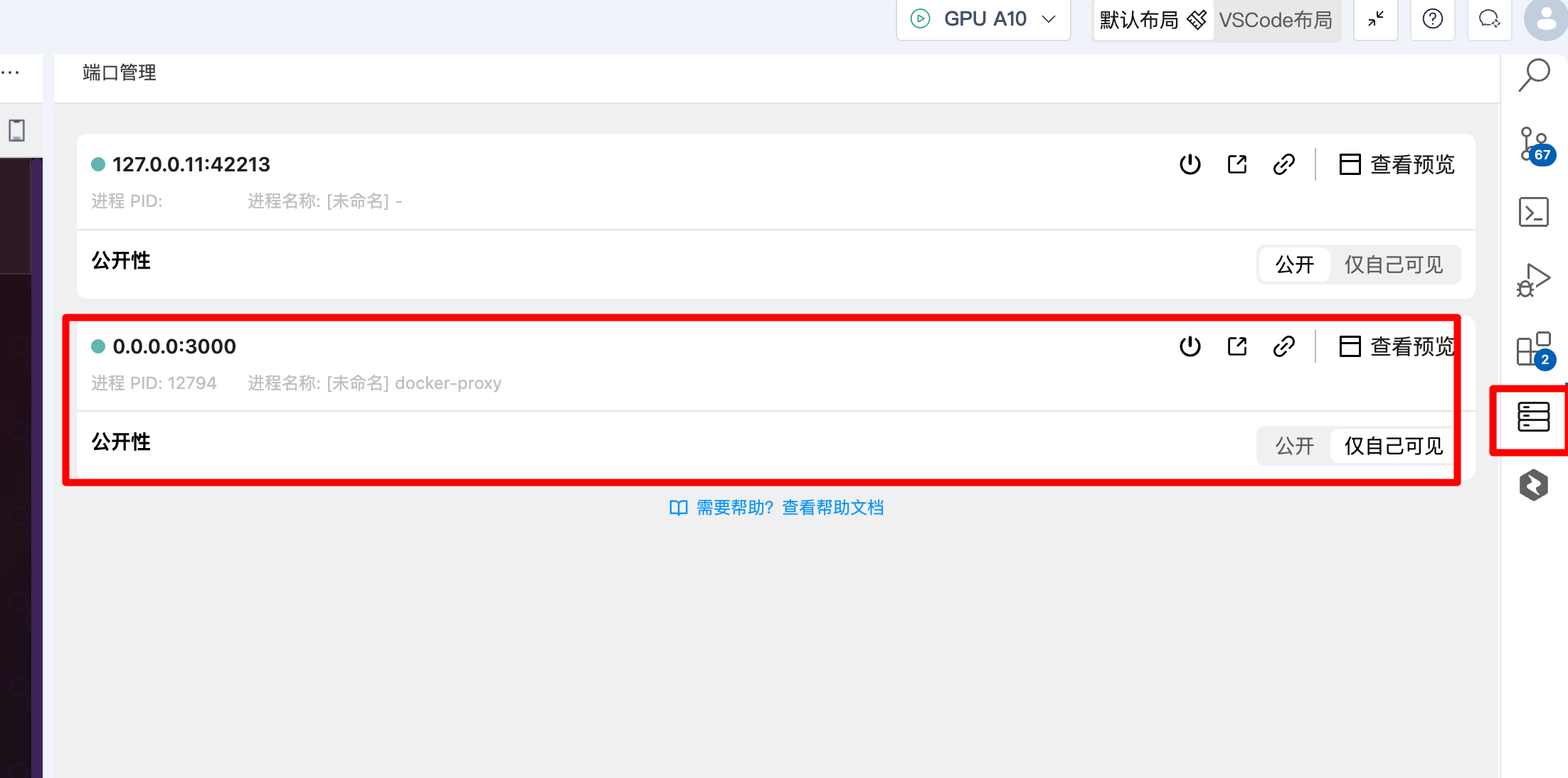

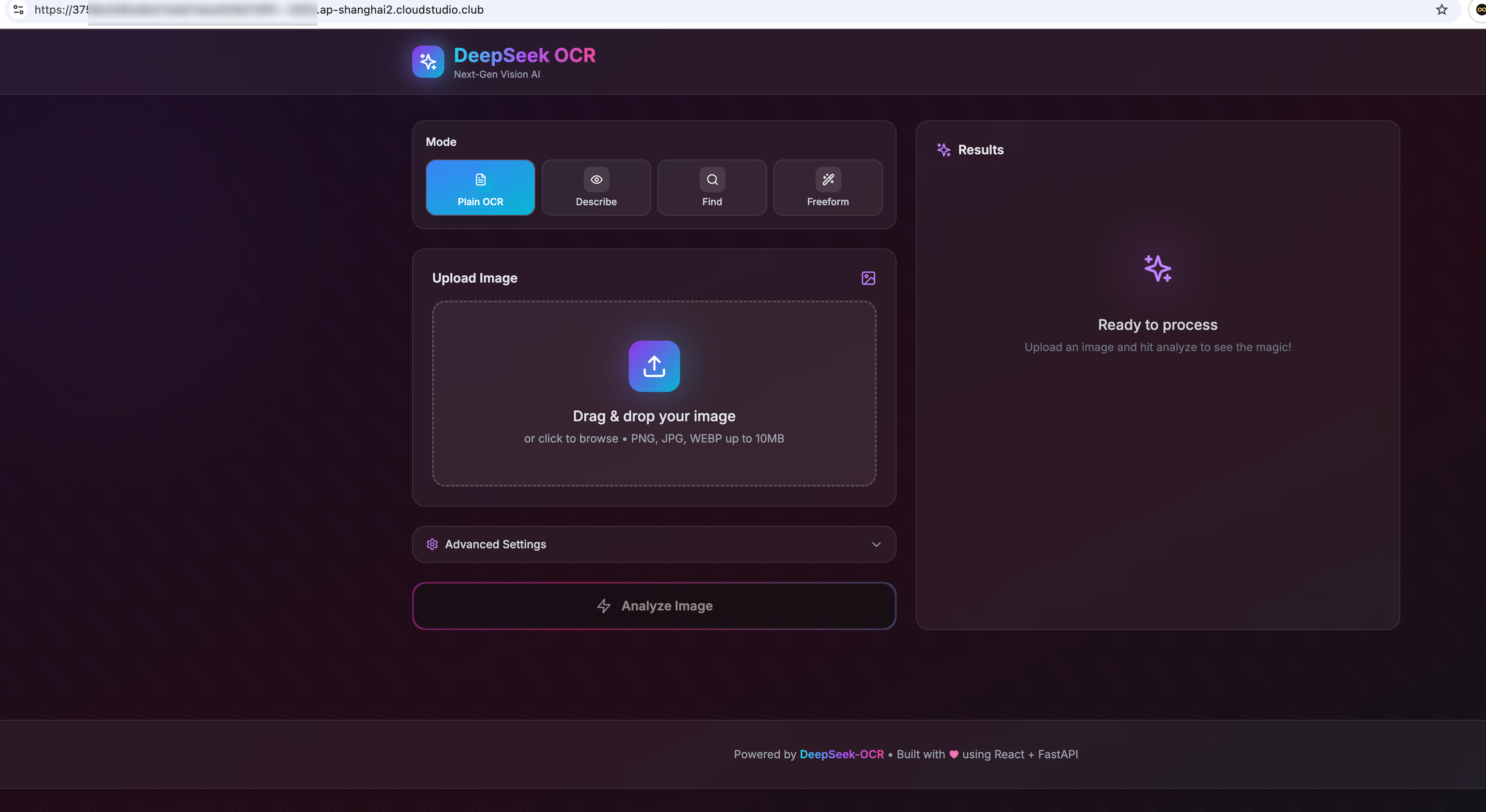

最后访问映射端口访问服务即可体验。

或则部署另外一个 web 项目:

git clone https://github.com/neosun100/DeepSeek-OCR-WebUI.git

cd DeepSeek-OCR-WebUI

docker-compose up -d --build测评效果

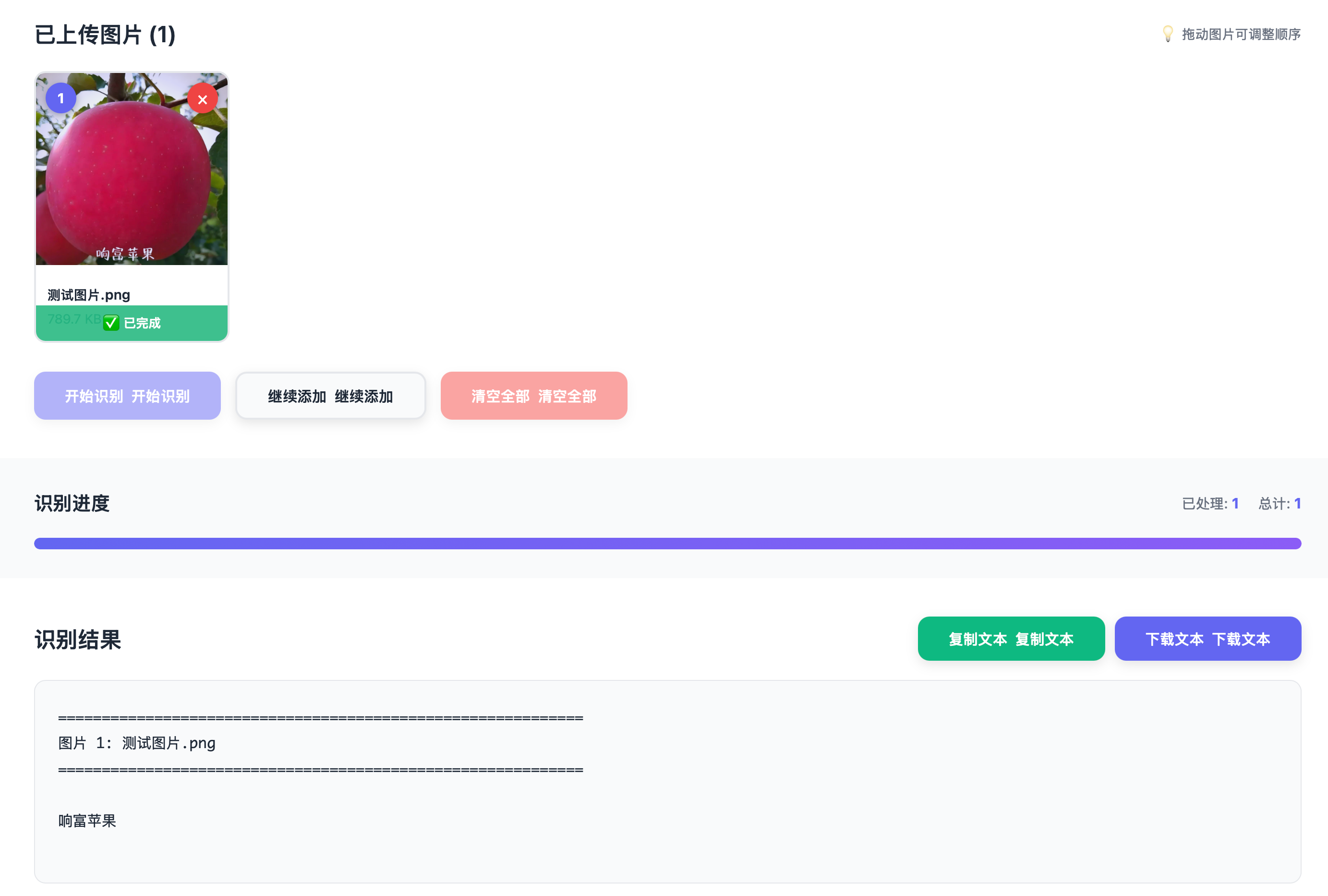

通用 ocr

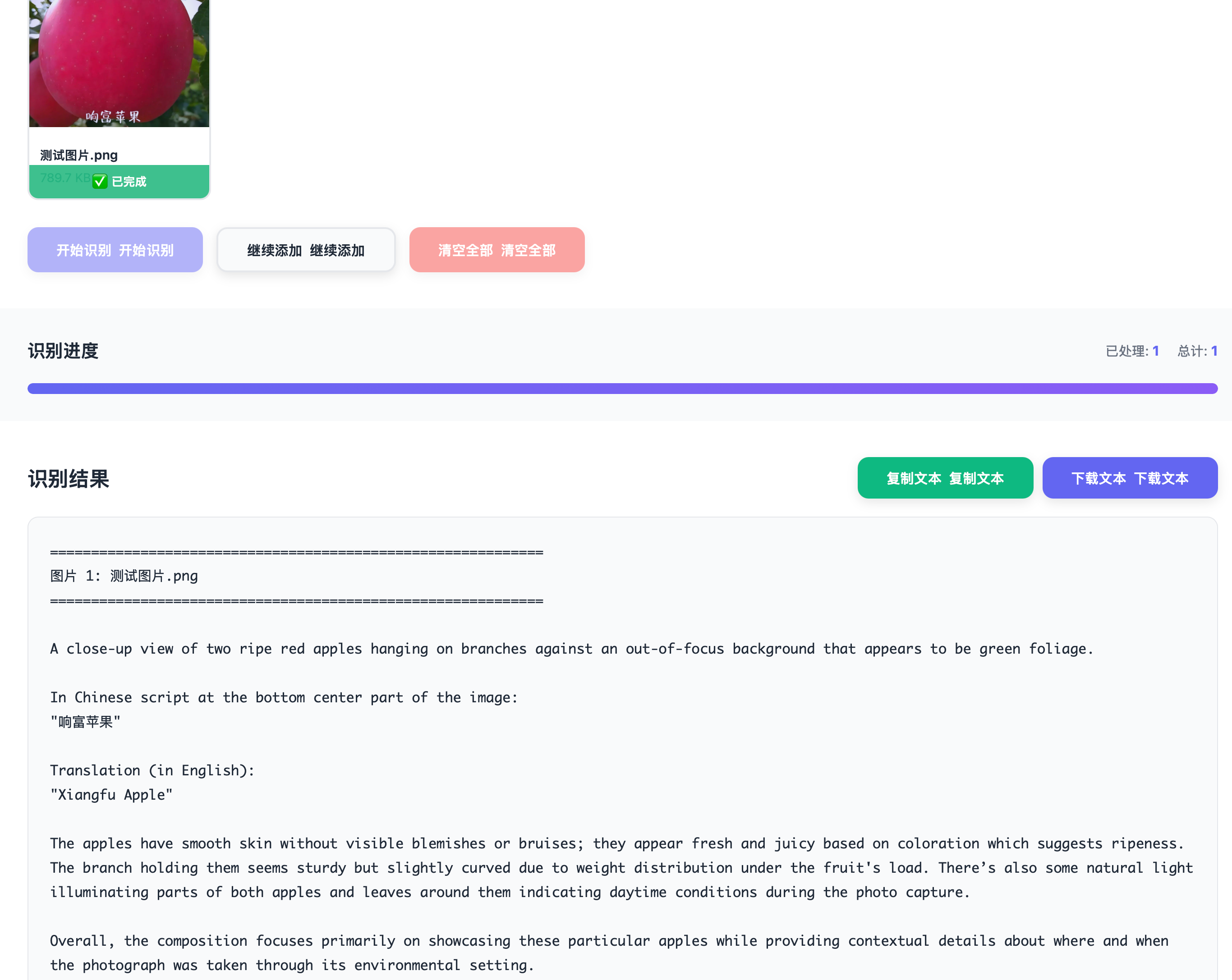

图片描述

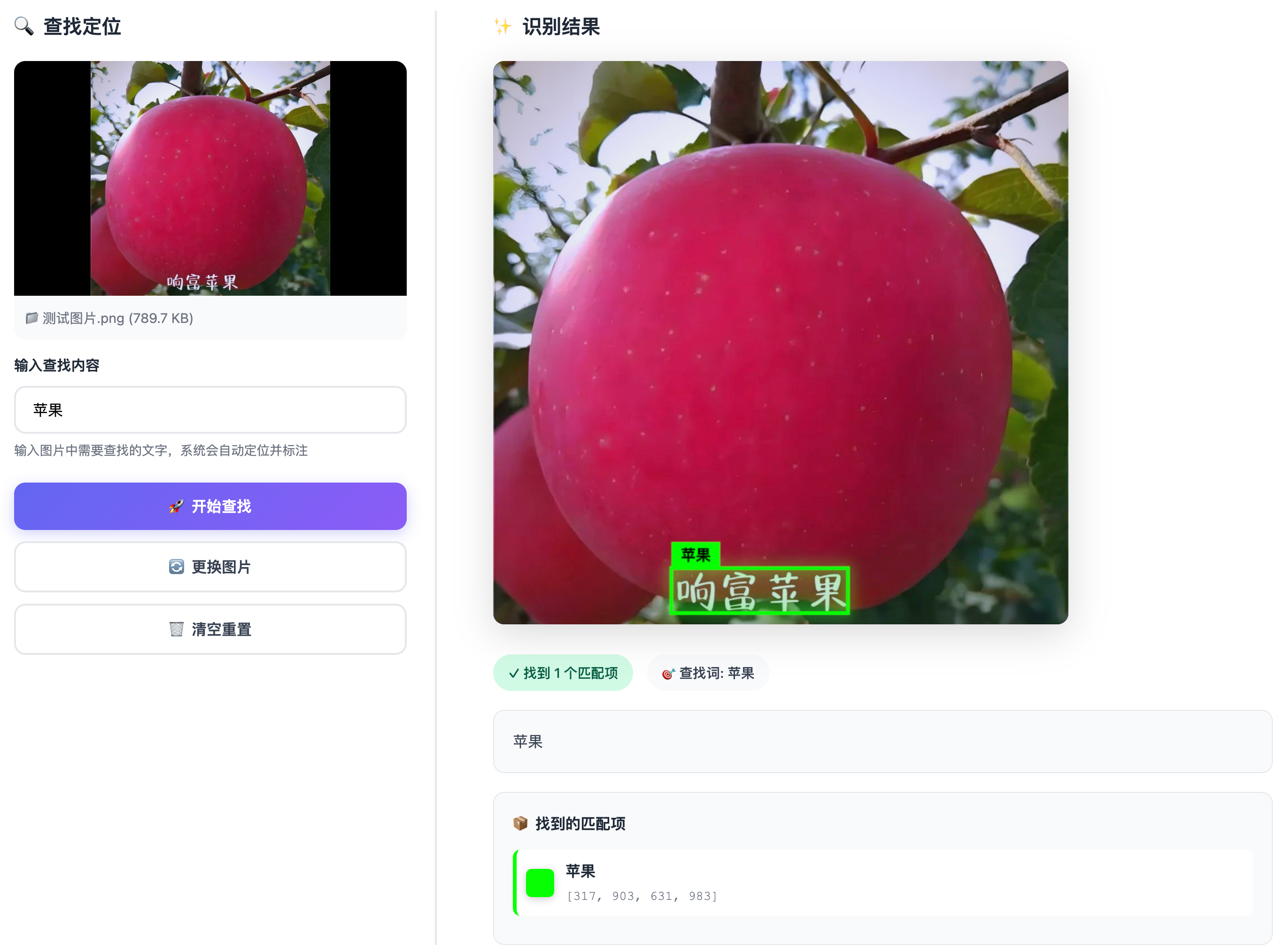

查找定位

更多功能大家可以自行部署测试,总体上来说还是不错的,可以作为 ocr 的补充。

参考链接

商业转载请联系作者获得授权,非商业转载请注明本文出处及文章链接